반응형

I. 확률적 경사 하강법의 개요

가. 확률적 경사 하강법(Stochastic Gradient Descent, SGD)의 정의

- 미분 가능한 함수인 경우 함수의 최소값은 변화율이 0인 지점으로 변화율이 0인 지점을 모두 찾고 어떤 포인트의 함수 값이 가장 작은지 확인하는 방법

II. 확률적 경사 하강법의 개념도 및 프로세스

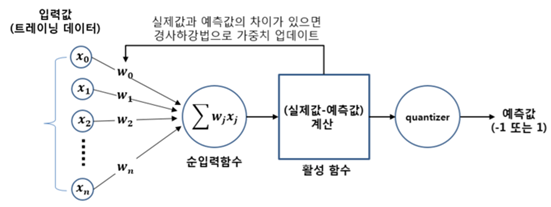

가. 확률적 경사 하강법의 개념도

|

나. 확률적 경사 하강법의 프로세스

|

단계 |

설명 |

|

1 |

- 훈련 샘플 x와 상응하는 타깃 y의 배치를 추출 |

|

2 |

- x를 사용하여 네트워크를 실행하고 (forward pass 단계), 예측 y_pred를 산출 |

|

3 |

- y_pred와 y의 차이를 측정하여 배치에 대한 네트워크 손실 계산 |

|

4 |

- 네트워크 파라미터에 대한 손실함수의 그래디언트를 계산(Backward pass) |

|

5 |

- 그래디언트의 반대방향으로 파라미터를 조금 이동 |

- 곡선을 따라 일정 크기만큼 접선의 기울기 방향으로 내려가면서 그 값이 최소값인지 판단하여 결국 최소 지점까지 도달하는 방법

III. 확률적 경사 하강법을 이용한 신경망 학습

|

반응형

'IT기술노트 > 인공지능' 카테고리의 다른 글

| EU AI 규제안 (0) | 2021.04.26 |

|---|---|

| AI 기반 시스템의 AI 고유 특성 (0) | 2021.04.26 |

| GAN(Generative Adversarial Networks) (0) | 2021.03.06 |

| 오류 역전파(Backpropagation) 알고리즘 (0) | 2021.03.06 |

| Gradient (0) | 2021.03.06 |

| 손실함수(Loss Function) (0) | 2021.03.06 |

| exclusive OR 연산 (0) | 2021.03.06 |

| 활성화 함수 (0) | 2021.03.06 |

댓글